Zomerblog: Hoe ga je verantwoordelijk aan de slag met AI in de zorg?

20.08.2021

Van januari 2020 tot en met augustus 2021 ontwikkelde Hogeschool Vives in het kader van het ESF project ‘AI-toepassingen in ziekenhuizen: ethisch en juridisch bekeken’ een opleiding rond AI in de zorg. De focus in deze opleiding ligt op het stimuleren van reflectie en debat over juridische en ethische aspecten bij de toepassing van AI in het ziekenhuis. Die reflectie is enorm belangrijk bij AI-systemen in de zorg, omdat het gebruik van AI risico’s en complexe vraagstukken meebrengt waarvoor momenteel nog geen sluitende antwoorden of procedures bestaan. Als een AI-systeem bijvoorbeeld een verkeerde diagnose suggereert, wie is hiervoor dan aansprakelijk? Wiens belangen moeten centraal staan als er data gedeeld wordt in functie van het trainen van een AI-systeem dat kanker sneller kan detecteren? Riskeert het inzetten van AI in de zorg niet het menselijke aspect van de zorg te verdringen, of zorgt AI net voor meer tijd voor interactie tussen zorgverlener en patiënt?

Vooronderzoek: believers, non-believers en nog veel onwetendheid

Bevraging van de ziekenhuizen

In de eerste fase trokken we naar het werkveld om zicht te krijgen op de uitbouw van AI-toepassingen in de zorg, de houding ertegenover, en de noden omtrent juridische en ethische knowhow om AI op een verantwoordelijke manier te implementeren in de zorg. Via interviews en focusgroepen hebben we verschillende ziekenhuizen, artsen, managers, verpleegkundigen, IT’ers en ethici bevraagd. Hierbij viel op dat sommige ziekenhuizen al best ver staan in de planning en/of implementatie van AI-systemen. Hierbij konden we, naast de mensen die geen uitgesproken mening hadden, een onderscheid maken tussen twee groepen: de zogenaamde believers: mensen binnen het ziekenhuis die beschouwd kunnen worden als sterke voorstanders of voorvechters van AI en die geloven dat AI voor een revolutie kan zorgen in de gezondheidszorg; en de non-believers: mensen die kritische vraagtekens plaatsen bij de implementatie van AI in de zorg of die het belang van AI of het vernieuwende aspect hiervan minimaliseren. Daarnaast merkten we ook op dat de ziekenhuizen nog zoekende zijn in het uitbouwen van een juridisch-ethisch beleid rond AI, temeer omdat de Europese wetgeving hier vooralsnog weinig tot geen concrete handvaten voorziet. Bovendien is er veel onwetendheid en twijfels over wat nu wel en niet mag of moet van de GDPR, bijvoorbeeld wat betreft informed consent of anonimisering.

Bevraging van burgers

Om zicht te krijgen op bezorgdheden van burgers – en dus (mogelijke) patiënten – en hun houding tegenover AI in de zorg, zetten we daarnaast ook een burgerbevraging op. Hiermee peilden we naar de kennis en houding van burgers tegenover AI in de zorg en de GDPR-wetgeving. De online bevraging liep van 26 mei tot 12 juli 2020 en 427 mensen vulden de vragenlijst volledig in.

Houding tegenover AI in de zorg.

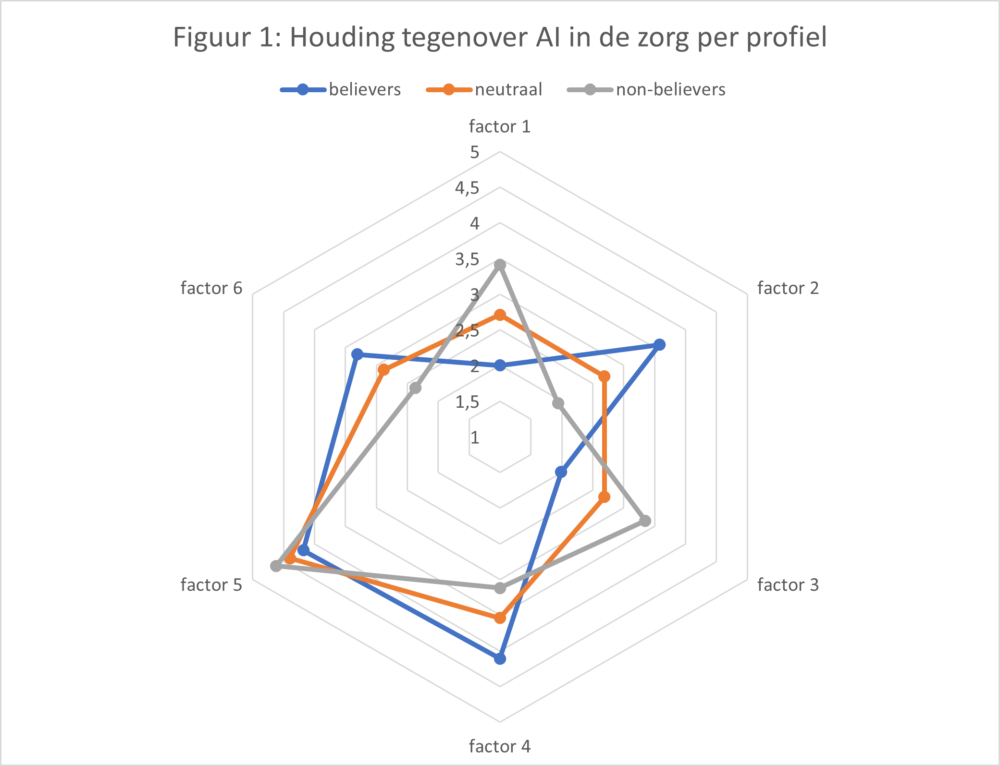

De 25 vragen (afgeleid uit bestaande instrumenten) die peilden naar de houding tegenover AI in de zorg werden via factoranalyse herleid tot volgende zes factoren:

- Wantrouwen ten aanzien van AI (hogere score = meer wantrouwen)

- Vertrouwen in AI en de gevolgen ervan (hogere score = meer vertrouwen)

- Vertrouwen in een arts die al dan niet AI gebruikt (lagere score = meer vertrouwen in een arts die voluit gebruik maakt van AI; hogere score = meer vertrouwen in een arts die AI niet gebruikt of enkel voor zeer specifieke taken)

- Verbeterde zorg door het gebruik van AI (hogere score = betere zorg door het gebruik van AI)

- Belang van menselijke contact in de zorg (hogere score = meer belang aan het menselijke contact)

- Conservatief vs progressief bij inschatting overlevingskans (lagere score = iedereen moet altijd behandeld worden; hogere score = een arts en/of AI mag beslissen of een behandeling zinvol is)

Via clusteranalyse zochten we vervolgens naar antwoordpatronen op deze zes factoren. We vonden, gelijkaardig met wat we vonden in de bevraging van ziekenhuizen, drie profielen van deelnemers: believers (N=87), non-believers (N=144) en een neutrale grootste groep zonder uitgesproken mening over AI (N=196). De groep believers bestaat verhoudingsgewijs uit meer mannen (59,3%) dan de non-believers (20,1%) en de neutrale groep (27,6%). De groep believers gaat sneller aan de slag met nieuwe technologie en geeft ook aan beter met ICT overweg te kunnen dan de andere groepen. Als het gaat over kennis van AI, zijn er ook meer believers die aangeven te weten wat AI inhoudt (90,8% tov 73,5% en 56,3% bij de non-believers) en ze kunnen ook beter AI-toepassingen onderscheiden van niet AI-toepassingen.

Figuur 1 geeft een visueel overzicht van de scores op de verschillende factoren per profiel. Iedereen hecht veel belang aan het menselijk contact in de zorg (factor 5), maar verder zijn er uitgesproken verschillen tussen de profielen in hun houding tegenover AI in de zorg. Believers hebben veel meer vertrouwen in AI en de gevolgen die het gebruik van AI in de zorg heeft (of zal hebben) (factor 2 en 4). Non-believers bevinden zich aan het andere eind van het spectrum (zie factor 1 en 3).

De vijf vragen met betrekking tot data, privacy en het verzamelen van gegevens via apps werden gereduceerd tot twee factoren: schrik om data te delen; en vertrouwen dat verzamelde data mezelf ten goede komt. De gemiddelde scores van de drie groepen verschillen significant van elkaar, believers hebben weinig schrik om data te delen en hebben vertrouwen dat de verzamelde data goed zal gebruikt worden, voor non-believers geldt het omgekeerde: meer schrik en minder vertrouwen. De neutrale groep scoort tussenin.

GDPR

Het merendeel van de deelnemers (86,7%) had al gehoord van de GDPR en 81,5% gaf aan de betekenis ervan te kennen. AI-believers geven aan beter op de hoogte te zijn dan de neutrale groep en de non-believers. Ze scoren ook hoger dan de andere groepen bij het beoordelen van stellingen met betrekking tot de GDPR: 5,54 op 8, tegenover 5,19 (neutraal) en 5,08 (non-believers).

Drie stappen naar verantwoordelijke implementatie van AI in de zorg

Doelgroep van de opleiding

De opleiding die we na dit vooronderzoek hebben opgebouwd bestaat uit drie delen en is gericht op verschillende functieprofielen in ziekenhuizen:

- Artsen die vormen van AI (zullen) gebruiken bij diagnose en/of behandeling

- Informatici die de systemen (zullen) ontwikkelen, uitrollen en/of beheren

- Verpleegkundigen die data registreren (of de data-registratie monitoren) die AI-systemen voeden

- Managers (in verschillende domeinen en op verschillende niveaus van het ziekenhuis) die verantwoordelijk zijn voor een AI-beleid

- Leden van ethische comité’s die beslissingen nemen over AI-toepassingen

De opleiding vertrekt vanuit het idee dat al deze mensen een belangrijke rol spelen in de AI-keten binnen het ziekenhuis, en dat je de implementatie van AI niet kan laten afhangen van het aantal believers of non-believers binnen het ziekenhuis. Het is van belang om iedereen mee te laten reflecteren over wat het betekent om op een verantwoordelijke manier aan de slag te gaan met AI in het ziekenhuis.

Eerste deel van de opleiding: e-learning

In een eerste deel van de opleiding bieden we een e-learning aan die de deelnemer op een ‘hands-on’ manier duidelijk maakt wat AI is, wat het niet is, en hoe het werkt. We staan ook stil bij de belangrijkste juridische en ethische aspecten die van belang zijn bij de implementatie van AI in de zorg, zoals privacy, aansprakelijkheid, afweging tussen verschillende belangen en doelen, de invloed op het menselijke aspect van de zorg, … Het idee achter deze e-learning is dat je nadien binnen het ziekenhuis eenzelfde referentiekader en taal hanteert, want het vooronderzoek toonde aan dat er nog veel twijfels en onwetendheid zijn binnen de ziekenhuizen als het gaat over AI en de belangrijke juridische/ethische aspecten. Zo een gedeeld referentiekader is het startpunt voor een ziekenhuis om een beleid rond de verantwoordelijke implementatie van AI concreet vorm te geven.

Tweede deel van de opleiding: videolezingen

In een tweede deel van de opleiding zoomen we via videolezingen van experten dieper in op één van de juridische en ethische onderwerpen, namelijk AI en datadeling, AI en aansprakelijkheid, en AI en het menselijke aspect van de zorg. Door de deelnemers de opdracht te geven om te reflecteren over de stellingen ingenomen in deze lezingen , proberen we stilaan de deelnemers te stimuleren tot het opbouwen van een eigen mening over de juridische en ethische aspecten van AI.

Derde deel van de opleiding: workshop

Deze mening proberen we te verdiepen én uit te breiden binnen een workshop in het ziekenhuis, wat het laatste deel vormt van de opleiding. In deze workshop zetten we de verschillende deelnemers uit de verschillende functieprofielen samen en laten we hen reflecteren en debatteren over de juridische en ethische implicaties en aandachtspunten van een heel concrete AI-toepassing, bij voorkeur een toepassing die reeds geïmplementeerd wordt in het ziekenhuis. Het doel is dat de deelnemers aan de hand van een concrete casus hun visie op een verantwoordelijke implementatie van AI kunnen vormgeven, die ze dan aan de hand van een aantal werkpunten kunnen uitdragen naar de patiënten toe. Zo hopen we dat ook de kloof bij patiënten tussen believers en non-believers verkleind wordt en dat iedereen overtuigd wordt van het potentieel van AI in de zorg, als het op een verantwoordelijke manier wordt gebruikt.

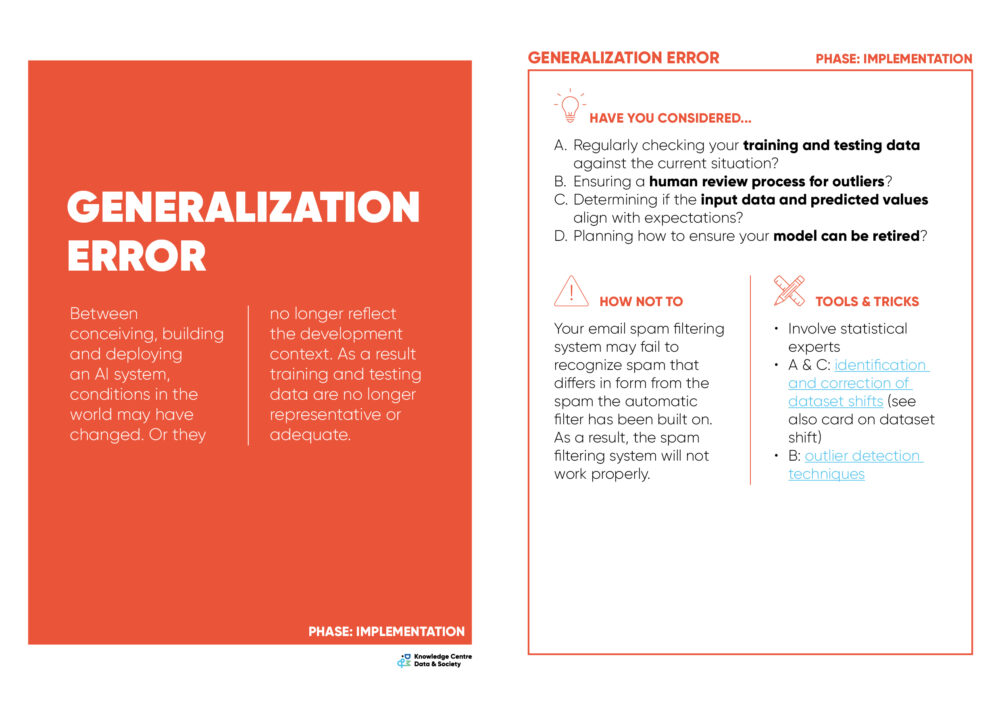

Tijdens de workshop gebruiken we een tool die we samen met het Kenniscentrum Data & Maatschappij ontwikkelden, namelijk de Blindspots healthcare kaartenset. Die set identificeert per kaart een andere juridisch-ethische blinde vlek waarmee je best rekening houdt als je AI implementeert in het ziekenhuis, zoals bijvoorbeeld ‘ongewenste impact’. Specifieke vragen worden gesteld om deze topics uit te diepen, er wordt een voorbeeld gegeven van een situatie waarin deze blinde vlek over het hoofd werd gezien, en er worden tools en tricks gegeven om aan de slag te gaan met deze blinde vlek.

De kaartenset bestond al in een algemene uitwerking, niet gericht op de zorgcontext. Omdat de inzet van AI in de zorgcontext heel veelbelovend is, maar tegelijk ook een aantal specifieke risico’s inhoudt, beslisten we samen met het Kenniscentrum om deze kaartenset toe te passen op de zorgcontext. De expertise van het Kenniscentrum rond ethiek en AI, hun methodieken om burgers hiervan bewust te maken en onze analyses van het vooronderzoek gevoerd in ziekenhuizen werden gecombineerd en dit leidde tot een bijzonder interessante en waardevolle tool! En dat vinden we niet alleen zelf, maar dat zeiden ook de mensen die deelnamen aan een testworkshop binnen één van de Vlaamse ziekenhuizen

Wil je ook graag met deze tool aan de slag? Klik dan op deze link voor meer info.

Wil je graag meer te weten komen over de opleiding en het onderzoek die hier werden voorgesteld? Stuur dan een mailtje naar chloe.delcour@vives.be

Photo by National Cancer Institute on Unsplash

Auteur

Chloë Delcour

onderzoeker expertisecentrum Sociale Innovatie

docent graduaat maatschappelijk werk en sociaal-cultureel werk

Hogeschool Vives

Studiegebied Sociaal-Agogisch Werk (SAW)

e-mail chloe.delcour@vives.be

Bram Pynoo

Hogeschool Vives

Domien Decloedt

Hogeschool Vives

Steven Wallaert

Hogeschool Vives