VS - Responsible AI Guidelines in Practice

De Defense Innovation Unit, onderdeel van het Amerikaanse Department of Defense, heeft richtlijnen voor verantwoorde AI afgekondigd. Deze richtlijnen gelden voor leveranciers van AI-producten of -diensten aan het Amerikaanse leger. De richtlijnen voorzien in een stapsgewijs proces dat bedrijven moeten volgen bij de planning, ontwikkeling en implementatie van AI-systemen. Ze bepalen procedures om vast te stellen wie de technologie zou kunnen gebruiken, wie er schade van zou kunnen ondervinden, wat die schade zou kunnen zijn en hoe die kan worden voorkomen - zowel voorafgaand aan de totstandkoming van het systeem als wanneer het eenmaal operationeel is.

Wat: richtlijnen voor leveranciers van AI-systemen

Impactscore: 2

Voor wie: AI-ontwikkelaars

Samenvatting

De Defense Innovation Unit (DIU), onderdeel van het Amerikaanse Department of Defense (DoD), heeft als taak om de Amerikaanse nationale veiligheid te versterken door de toepassing van commerciële technologie binnen de Amerikaanse defensie te faciliteren en te versnellen.

In die context kondigde het deze richtlijnen voor verantwoorde AI af die gelden voor leveranciers van AI-producten of -diensten aan het Amerikaanse leger. Het doel van deze richtlijnen is om ervoor te zorgen dat AI-leveranciers de eerder door het DoD afgekondigde ethische principes naleven. Meer specifiek bestaan de richtlijnen uit vragen die moeten worden behandeld in elke fase van de AI-levenscyclus: planning, ontwikkeling en implementatie. Zij bieden stap-voor-stap richtlijnen voor AI-bedrijven, DoD belanghebbenden en programma-managers om ervoor te zorgen dat AI-systemen in overeenstemming zijn met de ethische principes voor AI (o.a. eerlijkheid, verantwoording en transparantie) bij elke stap in de ontwikkelingscyclus. De DIU past de richtlijnen actief toe op een reeks projecten die toepassingen omvatten op het vlak van voorspellende gezondheid, onderwaterautonomie, voorspellend onderhoud, en toeleveringsanalyse.

De DUI erkent dat deze richtlijnen geen universeel toepasbare manieren bevatten om tekortkomingen te verhelpen, zoals bevooroordeelde gegevens (biased data), ongeschikte algoritmes of slecht gedefinieerde toepassingen, in elke situatie. Bovendien wordt ook erkend dat bij sommige systemen die worden aangeboden voor nationale veiligheidsdoeleinden wellicht geen verantwoorde inzet mogelijk is. Besluiten om een AI-systeem niet verder te ontwikkelen kan dan ook een aanvaardbaar resultaat zijn van het naleven van de richtlijnen. Ten slotte moeten de richtlijnen worden gezien als een aanvulling op de interne ethische beoordelingen en test- en evaluatieprocedures (T&E) die veel bedrijven die AI-producten leveren, hanteren.

Per fase in de AI-levenscyclus identificeert de DIU volgende afwegingen:

- Planning: definieer de taak, de succesparameters en de referentiepunten naar behoren; verkrijg toegang tot de gegevens die nodig zijn om het systeem te ondersteunen; identificeer belanghebbenden en missieverantwoordelijken; voer een gedetailleerde schadebeoordeling uit; ontwikkel processen om systeemfouten veilig aan te pakken en slecht functionerende systemen terug te draaien naar een eerder functionerende versie.

Download

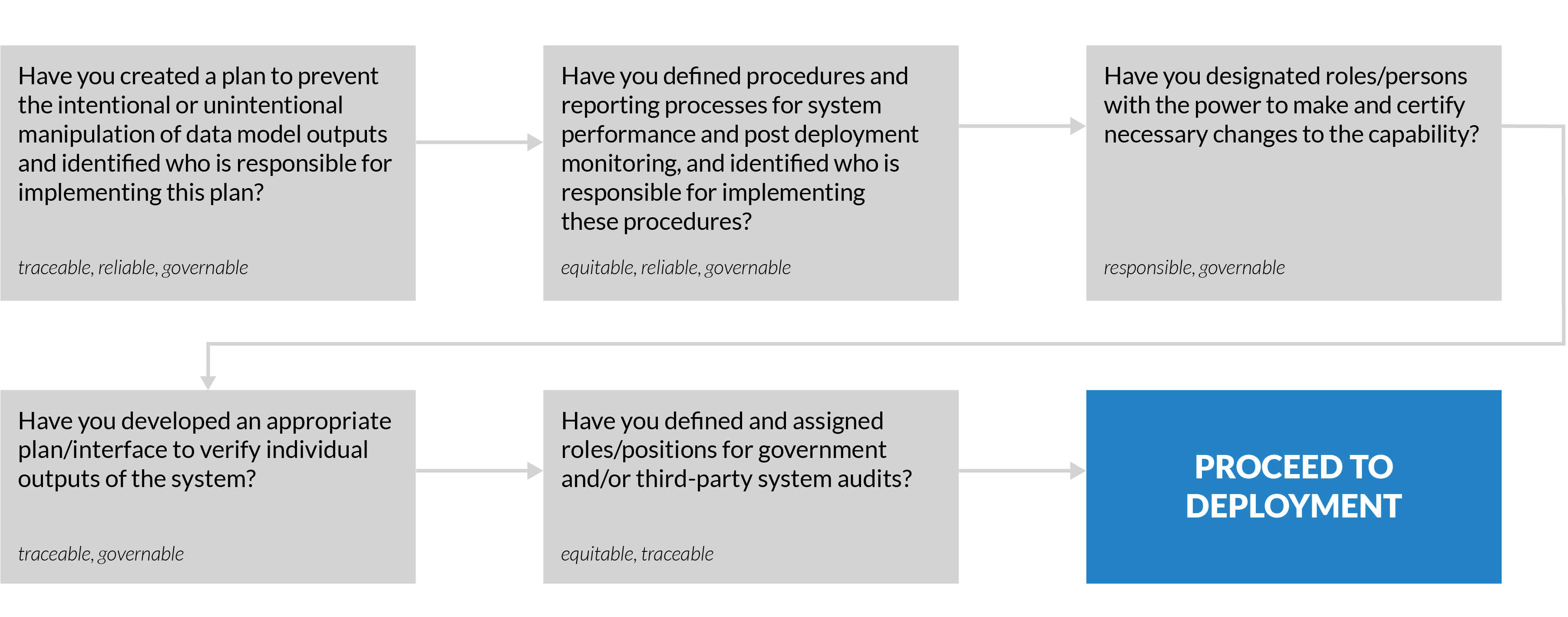

Download- Ontwikkeling: zorg ervoor dat de ontwikkelaars stappen ondernemen om de potentiële negatieve gevolgen van gegevens- of modelmanipulatie te beperken; stel parameters en indicatoren vast voor de monitoring na de ingebruikneming; wijs de bevoegdheid om wijzigingen aan te brengen aan het AI-systeem toe aan een specifieke verantwoordelijke partij ; ontwerp de systeeminterface zodanig dat de gebruikers de mogelijkheid hebben te begrijpen hoe outputs worden geproduceerd; en stel een plan voor routinematige systeemaudits.

Download

Download- Implementatie: voer voortdurend validatie van taken en gegevens uit om ervoor te zorgen dat de taakspecificatie en de gegevensinvoer geldig en veilig blijven; bevestig dat nieuwe gegevens de systeemprestaties niet verminderen; maak gebruik van functionele testen om te evalueren of het AI-systeem nog steeds de gewenste taak nog voldoende goed uitvoert om operationeel bruikbaar te zijn; en voorzie tevens schadebeoordelingen en kwaliteitscontroles om ervoor te zorgen dat potentiële negatieve gevolgen voor belanghebbenden voortdurend opnieuw worden beoordeeld en waar nodig geremedieerd.

Download

Download