Workshop: Fairness notions in action

Geeft de computer jou de job die je verdient?

Ervaar in deze workshop aan de lijve wat de mogelijkheden zijn voor een computer om je al dan niet eerlijk te beoordelen.

Machine Learning algoritmes worden gebruikt in allerlei takken van de samenleving. Toch zijn deze systemen vaak een black box waarvan het niet duidelijk is voor mensen hoe de beslissingen worden gemaakt. Er zijn al verschillende voorbeelden waarbij we als maatschappij vinden dat AI systemen bestaande vooroordelen (biases) herbevestigen. Denk daarbij aan gezichtsherkenningsoftware die bepaalde huidskleuren beter herkent dan anderen. Om dit te verhelpen kan een algoritme gemaakt worden dat rekening houdt met deze vooroordelen door bepaalde ‘fairness principes’ toe te passen. Er bestaan echter vele verschillende definities en iedereen heeft een eigen mening over welke nu de beste is. In deze workshop ervaar je hoe een AI algoritme mensen probeert te selecteren op een eerlijke manier. Er zijn hiervoor vele verschillende definities en uitwerkingen beschikbaar. Deze verschillende opties worden doorlopen en bediscussieerd tijdens de workshop.

Praktische details

Soort: fysieke workshop

Duur: 1,5 uur

Leeftijd: 16-99 jaar

Wil je meer weten over de workshop? Contacteer dan Jonne van Belle

Deze workshop is onderdeel van het IRP COMPASS project van de Vrije Universiteit Brussel

De fairness principes

Lees hieronder meer over de fairness principes die we tijdens de workshop behandelen. Wie wordt er uitgenodigd om op gesprek te komen voor de job en wie niet? Welke van deze principes vind jij het meest fair?

Input data

Dit zijn de mensen die hun CV hebben opgestuurd om te solliciteren voor de job.

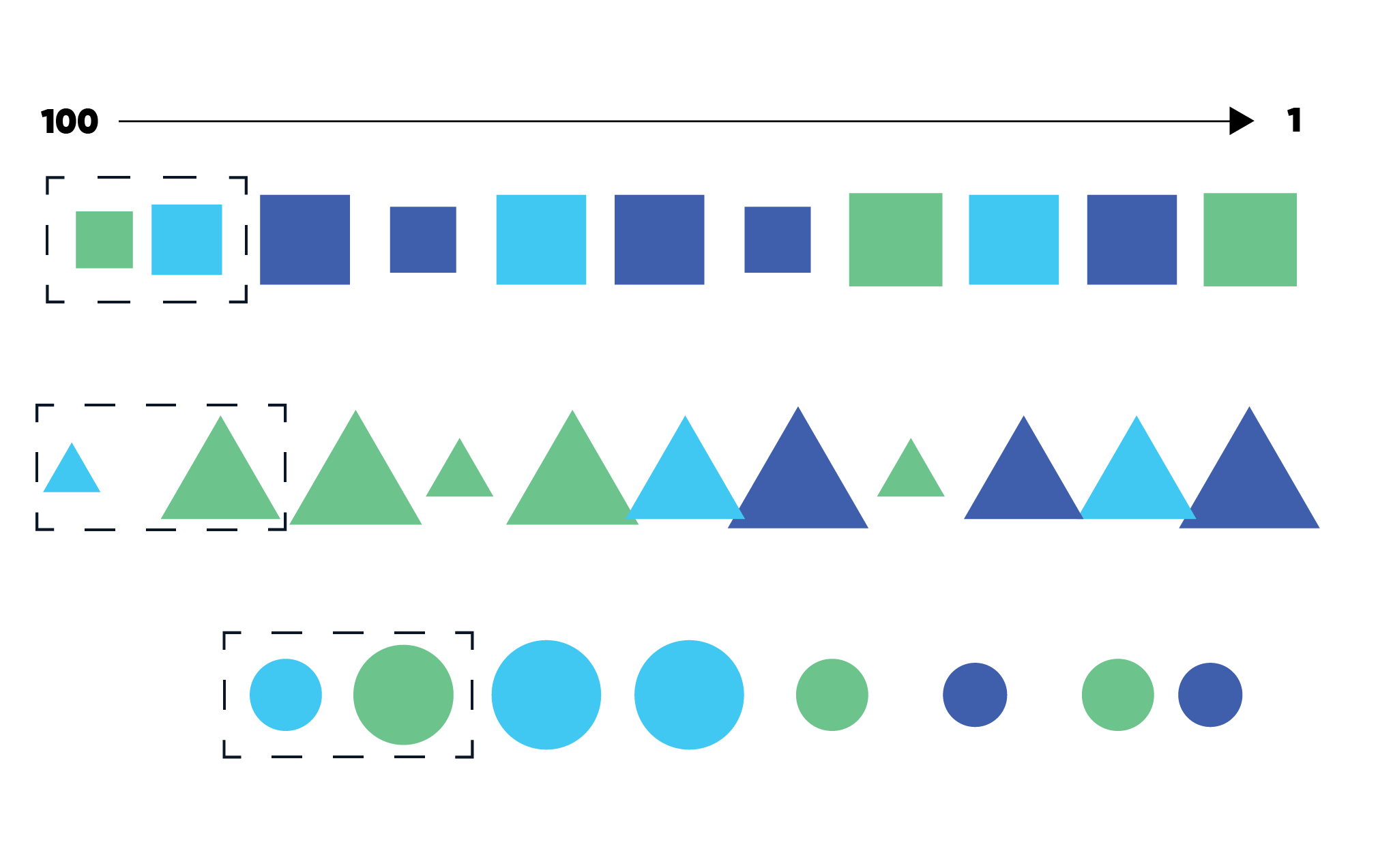

Het algoritme

Het algoritme berekent op basis van veel historische data een score tussen de 1 en de 100. De mensen met de hoogste score worden uitgenodigd om op gesprek te komen.

Statistical parity

Door statistical parity toe te passen op je algoritme, worden de kandidaten gesorteerd op bepaalde (beschermde) karakteristieken, in dit geval de vorm. Op die manier kan je zorgen dat er van elke groep evenveel mensen kunnen worden uitgenodigd voor een gesprek en elke groep evenredig wordt meegenomen in het selectieproces.

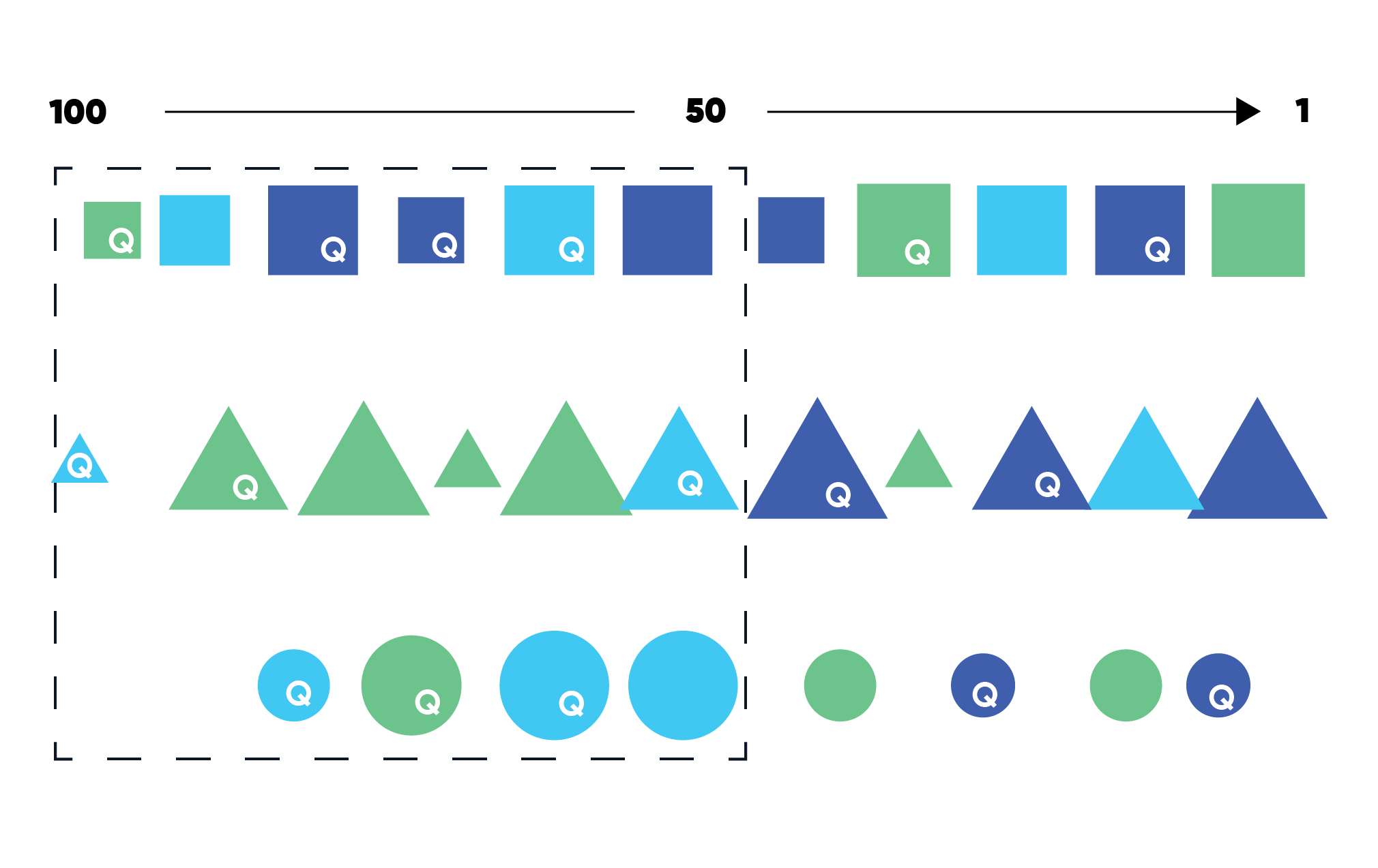

Equal opportunity

In plaats van zes mensen uit te nodigen op gesprek, kan een bedrijf er ook voor kiezen om iedereen die een bepaalde score of meer heeft behaald uit te nodigen. We noemen dat een drempelwaarde. In dit voorbeeld ligt de drempelwaarde op score 50.

De Q duidt aan dat deze persoon ook echt gekwalificeerd is voor de job. Met het fairness principe equal opportunity ga je na of de foutenmarge voor personen die gekwalificeerd zijn maar niet boven de drempelwaarde liggen gelijkaardig is in elke groep.

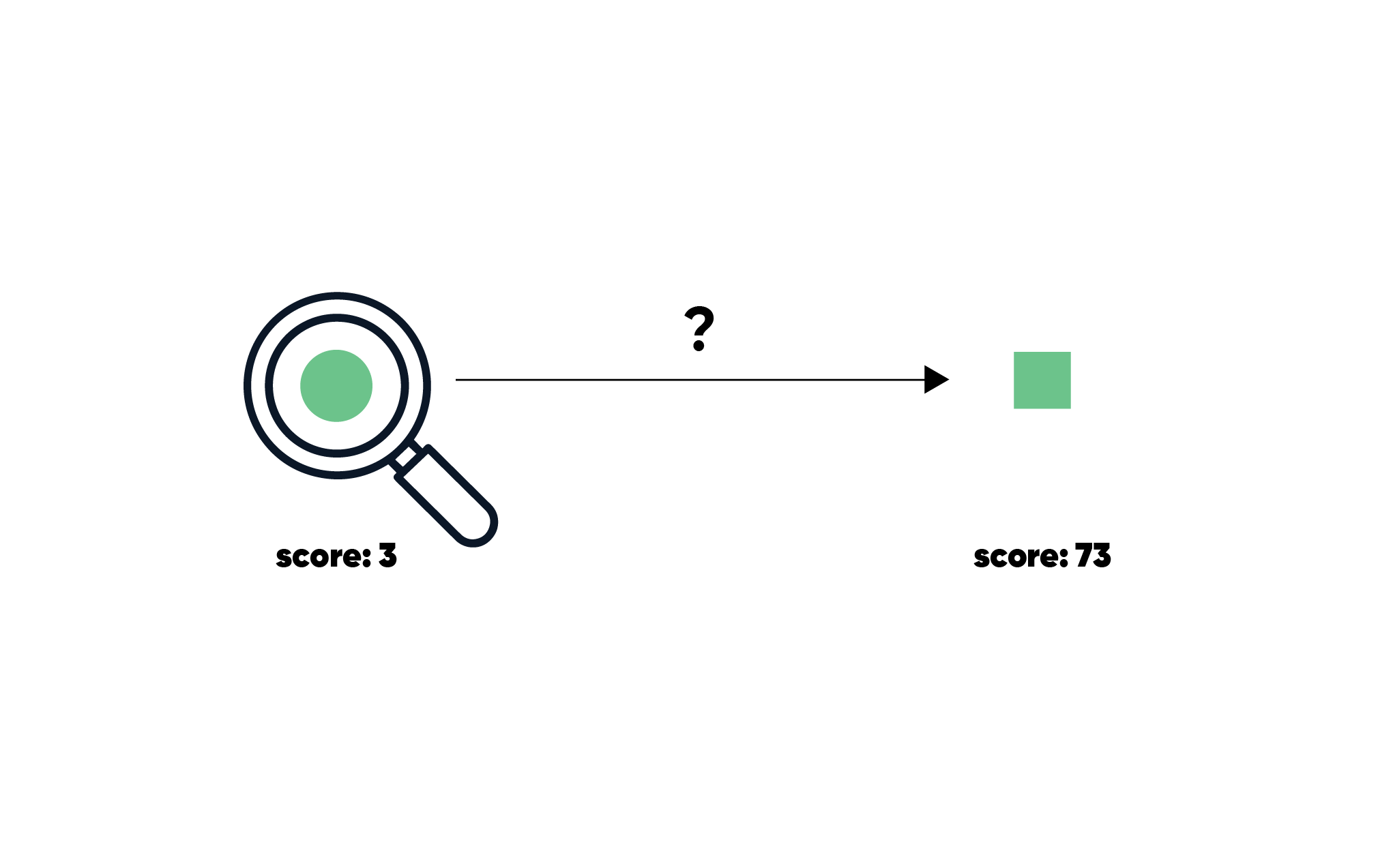

Causal discrimination

De vorige principes keken elk naar de verschillende groepen. We kunnen ook vanuit het individu kijken, dit heet dan individuele fairness. Met causal discrimination kunnen we bijvoorbeeld checken of iemand met dezelfde karakteristieken behalve eentje een hele andere score ontvangt. Als dit zo is bij een karakteristiek dat wettelijk beschermd is, zoals gender of etniciteit, dan is je algoritme niet fair en correct.

De workshop is gebaseerd op de fairness notions zoals beschreven door Makhlouf et al. (2021). Wil je er meer over lezen en ook nog andere fairness principes ontdekken? Je kan het artikel hier terugvinden.