Aequitas

De Aequitas tool voert een audit uit voor je project. Deze methode is bedoeld om te analyseren of er vooroordelen aanwezig zijn in de data en in de modellen die je gebruikt. Je kan de audit kan uitvoeren via de desktop of online tool.

De methode is ontwikkeld door het Center for Data Science and Public Policy. Dit onderzoekscentrum heeft als doel om het gebruik van data science in publiek beleid onderzoek en praktijk te stimuleren.

Wat je wil weten voor je verder leest

- Voor wie: ontwikkelaars, beleidsmakers

- Procesfase: probleemanalyse en ideatie, evaluatie en iteratie

- Systeemonderdeel: gehele toepassing, gebruikers, context AI systeem

- Prijs: vrij beschikbaar

Twee soorten audits

Een eerste audit bekijkt of er vooroordelen in acties of interventies hebben plaatsgevonden op een manier die niet representatief is voor de populatie. Dit wil zeggen dat er wordt gekeken of de acties of interventies niet ongelijk verdeeld zijn. Zo kan door keuzes bij de data collectie een bepaalde bevolkingsgroep onzichtbaar zijn. Dit heeft als gevolg dan een andere groep meer aandacht krijgt dan eerlijk is. Een voorbeeld hiervan is hier te vinden.

De tweede audit bekijkt of er een vooroordeel is over een deel van de populatie door verkeerde aannames van het AI-systeem. Een concreet voorbeeld hiervan zou zijn wanneer een AI-systeem ontwikkelt voor het beoordelen van kredietwaardigheid de aanname maakt dat aankopen in een nachtwinkel een teken is van onbetrouwbaar gedrag. Deze aanname is oneerlijk wanneer blijkt dat de nachtwinkel soms de enige plek is waar levensmiddelen te koop zijn.

Voorbereiding

Deze toolkit bestaat uit een online en een offline versie. Wanneer je gebruik maakt van de online versie, is er een duidelijke omschrijving nodig van de populatie en de subgroep die je wil bekijken (denk aan ras of gender). Verder is het ook nodig om informatie te hebben over uitkomsten van het systeem, dus een zicht op de acties die het systeem aanbeveelt richting bepaalde personen. Dit type audit gebeurt vaak achteraf, men raadt dan ook aan om te werken met resultaten die voortkomen uit daadwerkelijk gebruik van het AI-systeem.

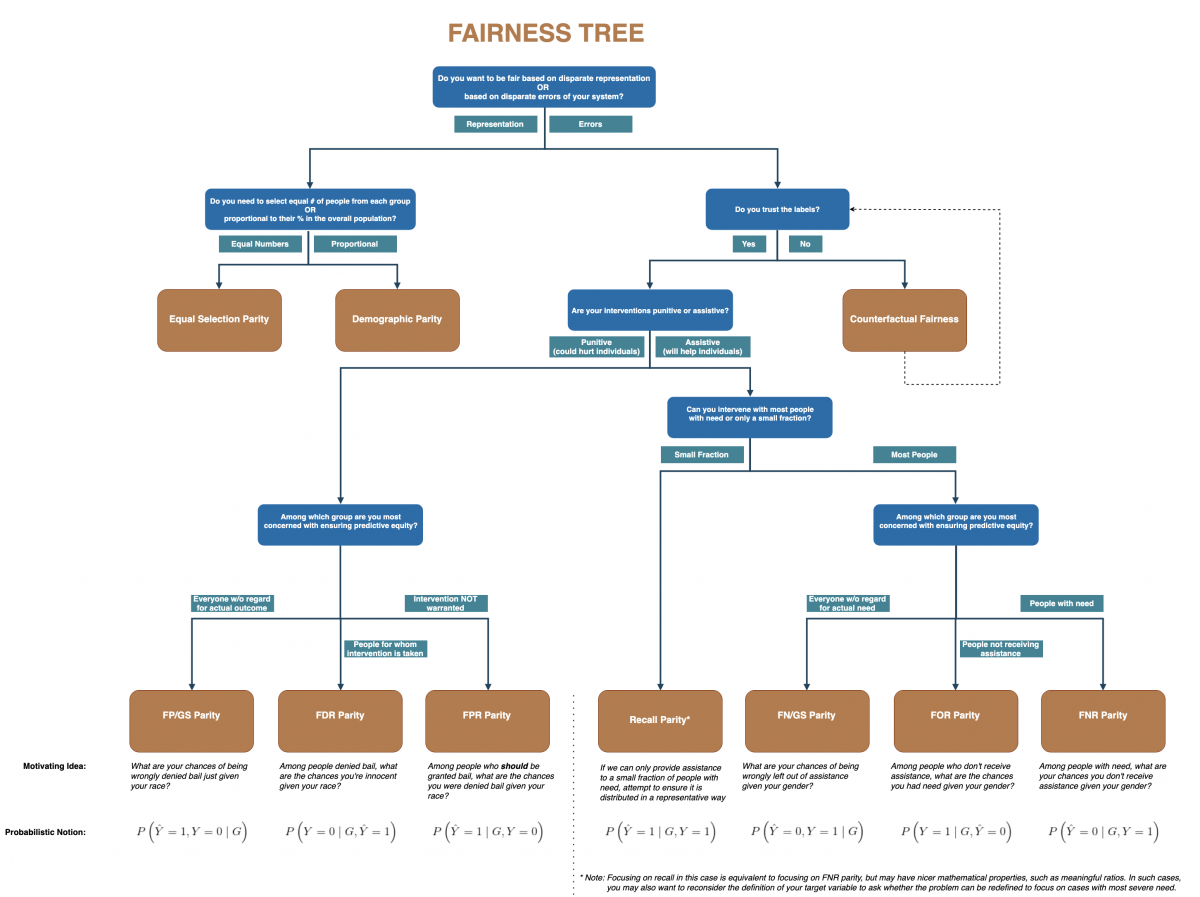

De tool biedt de optie om de audit offline te doen, via de desktopversie of in python. In ieder geval moet de data voorbereid worden voor deze audit. Verder is er ook een beslissingsboom die je kunt gebruiken om te bepalen welk soort gelijkheid/audit geschikt is voor jouw toepassing. De beslisboom die hieronder is weergegeven kan je hiermee helpen. Deze kan je ook hier vinden.

Methode

Het systeem bestaat uit een beslissingsboom die je helpt beslissen welk soort gelijkheid je wil bereiken, zie de beslisboom hierboven. Daarnaast heb je een toolkit die een auditrapport verzorgt en verschillende digitale mogelijkheden (codes die je kan toevoegen in je eigen python codes om gelijkheid te bereiken) die tijdens het programmeren helpen met het identificeren van gelijkheid in de data.

Uitkomst

Je kunt ofwel tijdens de ontwikkeling van de toepassing op de hoogte worden gehouden van de mate van gelijkheid in de data, of je kan achteraf op basis van data een auditrapport laten opstellen via de online of desktop tool.

| Waarden zoals benoemd in de tool |

Gerelateerde ALTAI-principes |

|---|---|

|

|

|

|

Link

Deze tool werd niet ontwikkeld door het Kenniscentrum Data & Maatschappij. We beschrijven de tool op onze website omdat die je kan helpen bij het behandelen van ethische, juridische of maatschappelijke aspecten van AI-toepassingen. Het Kenniscentrum is niet verantwoordelijke voor de kwaliteit van de tool.