De Europese AI-regelgeving: wat houdt het voorstel in?

24.04.2021

De Europese Commissie heeft haar langverwachte voorstel van regelgeving voor artificiële intelligentie (AI) bekendgemaakt. Dit zal van de Europese Unie (EU) de eerste regio ter wereld maken met specifieke regels voor AI. Met de wetgeving wil de Commissie geharmoniseerde regels vastleggen voor het op de markt brengen, het in dienst nemen en het gebruik van AI-systemen in de EU. We vatten het wetsvoorstel hier voor jou samen.

De voorgestelde regels moeten zorgen voor een beter functionerende Europese interne markt op het vlak van AI en voor bescherming van de gezondheid, veiligheid en de fundamentele rechten en vrijheden van burgers. De Commissie hoopt zo dat zij, door als eerste regels te introduceren, de wereldwijde norm voor AI-regelgeving kan vastleggen. Het voorstel bouwt voort op het witboek AI dat in februari 2020 door de Europese Commissie werd gepubliceerd en gevolgd werd door een openbare consultatiefase die liep tot juni 2020. Lees hier de bijdrage van het Kenniscentrum aan het consultatieproces.

Waar het witboek de nadruk legde op het mondiale concurrentievermogen van de EU, benadrukt de nieuwe verordening sterker de bescherming van de grondrechten. Zo bevat het voorstel onder andere een verbod op AI-praktijken die worden strijdig geacht met de waarden en grondrechten van de EU en een uitgebreid hoofdstuk betreffende AI-systemen met een hoog risico.

Doel

Volgens de Commissie biedt AI-technologie de landen in de EU een ruime waaier aan opportuniteiten, zoals maatschappelijke voordelen, economische groei en de versterking van het innovatie- en concurrentievermogen. De Commissie wil die kansen benutten, maar wil er tezelfdertijd voor zorgen dat bij de ontwikkeling en implementatie van AI de mens centraal blijft staan. Het basisidee is dat AI-systemen in Europa veilig moeten zijn, de gezondheid van personen niet in gevaar brengen, robuust en betrouwbaar zijn en de fundamentele rechten en vrijheden niet schenden.

Een uniform en geharmoniseerd regelgevend kader zorgt voor rechtszekerheid voor bedrijven, wat nodig is om investeringen en innovatie in AI te vergemakkelijken. Dergelijk kader voorkomt ook dat de Europese interne markt versnipperd wordt met uiteenlopende regelgeving per lidstaat.

Voor wie?

De ontwerpverordening heeft betrekking op:

- het in de handel brengen,

- het in dienst stellen

- en het gebruik van AI-systemen in de EU

Training van AI zou niet onder de verordening vallen. Echter, indien AI-systemen getraind worden met persoonsgegevens, is de Algemene Verordening Gegevensbescherming (AVG) van toepassing.

De nieuwe regels zouden van toepassing zijn op publieke en private actoren binnen en buiten de EU die:

- AI-systemen in de EU op de markt brengen

- AI-systemen in gebruik nemen en daarmee invloed hebben op personen binnen de EU

- Actoren die AI-output produceren in een land buiten de EU, maar waarvan de geproduceerde output in de EU gebruikt wordt

De regels zouden niet van toepassing zijn op overheidsinstanties van niet-EU-landen en internationale organisaties onder bepaalde omstandigheden zoals internationale rechtshandhaving. Militaire AI-systemen zouden ook worden vrijgesteld, net als particulier en niet-professioneel gebruik.

Wat is de impact?

De nieuwe tekst wil ethische vraagstukken wettelijk verankeren (zoals de beperking van vooroordelen ("bias"), algoritmische transparantie en menselijk toezicht op geautomatiseerde machines). Het bevat onder andere:

- Verbodsbepalingen voor bepaalde AI-systemen

- Vereisten voor AI-systemen met een hoog risico

- Transparantieregels voor AI die bedoeld is voor interactie met mensen

- Regels voor markttoezicht en -bewaking.

Impact voor bedrijven

Bedrijven die AI-systemen voor de Europese markt willen ontwikkelen of AI-systemen op de markt willen brengen, krijgen enerzijds normen opgelegd en anderzijds rechtszekerheid. Terwijl de invoering van het verantwoordingsprincipe in de AVG organisaties verplichtte praktische maatregelen in te voeren om de naleving aan te tonen, zou de nieuwe AI-regulering nog ambitieuzer zijn. Zo zouden aanbieders van AI-systemen met een hoog risico moeten uitgebreide procedures op vlak van beheer ("governance") en risicobeheer moeten implementeren (zie het hoofdstuk ‘De risicogebonden aanpak’ voor meer details). Er zouden ook conformiteitsbeoordelingen moeten worden uitgevoerd om aan te tonen dat aan de eisen van de verordening wordt voldaan.

De tekst doet geen toegevingen aan KMO’s en/of startups. Deze doelgroep zal wel prioritair toegang krijgen tot wettelijke "sandboxes", maar het zal voor hen, net zoals onder de AVG, waarschijnlijk veel energie en middelen vragen om een AI-systeem met een hoog risico te ontwikkelen, aan te kopen of te gebruiken. Dit kan een impact hebben op innovatie en jobcreatie.

Impact voor gebruikers

Organisaties en sectoren die AI willen gebruiken zullen verschillende controlemechanismen moeten hanteren. De gebruiker zou zich moeten houden aan een reeks technische instructies die door de aanbieder van het AI-systeem worden opgesteld en de operationele prestaties van het AI-systeem daarop controleren.

De inhoud van deze instructies zou geval per geval moeten worden vastgesteld en wordt door de verordening niet verder gespecificeerd. Dit kan mogelijk voor gebruikers tot onzekerheid leiden over de omvang en aard van hun nalevingsverplichtingen (De AVG voorziet echter wel al bepaalde rechten indien er sprake is van geautomatiseerde besluitvorming).

Impact voor burgers

De tekst voorziet transparantievereisten, maar er zijn weinig mechanismen voor burgers die direct beïnvloed worden door AI-systemen om te protesteren of klacht in te dienen indien er iets misloopt.

Definitie

De tekst voorziet een ruime definitie van een AI-systeem:

“Software die is ontwikkeld met behulp van een of meer van de in bijlage I genoemde AI-technieken (machine learning-technieken, statistische technieken en op logica en kennis gebaseerde technieken) en benaderingen, en die, voor een gegeven reeks door mensen gedefinieerde doelstellingen, uitkomsten kan genereren zoals inhoud, voorspellingen, aanbevelingen, of beslissingen die van invloed zijn op de omgevingen waarin zij interageren.”

De definitie werd zo neutraal mogelijk gehouden om ook technieken te kunnen omvatten die nog niet bekend of ontwikkeld zijn. Het doel is om alle AI te bestrijken, met inbegrip van hybride systemen.

Toepassingsgebied

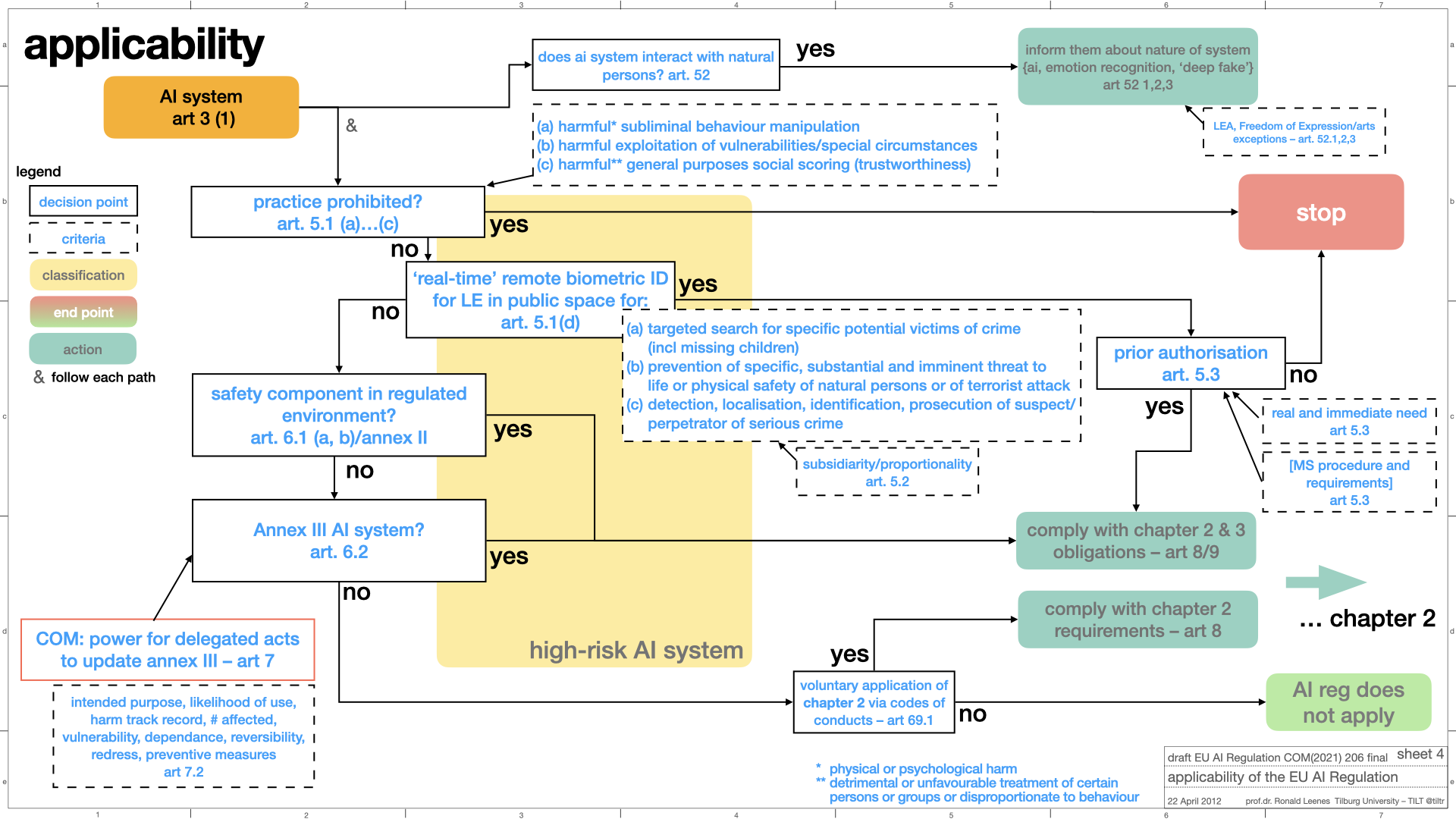

Het toepassingsgebied van de AI-verordening werd in een visueel overzicht gegoten door Ronald Leenes, hoofd van het Departement Law, Technology and Society van de Tilburg University.

© Ronald Leenes

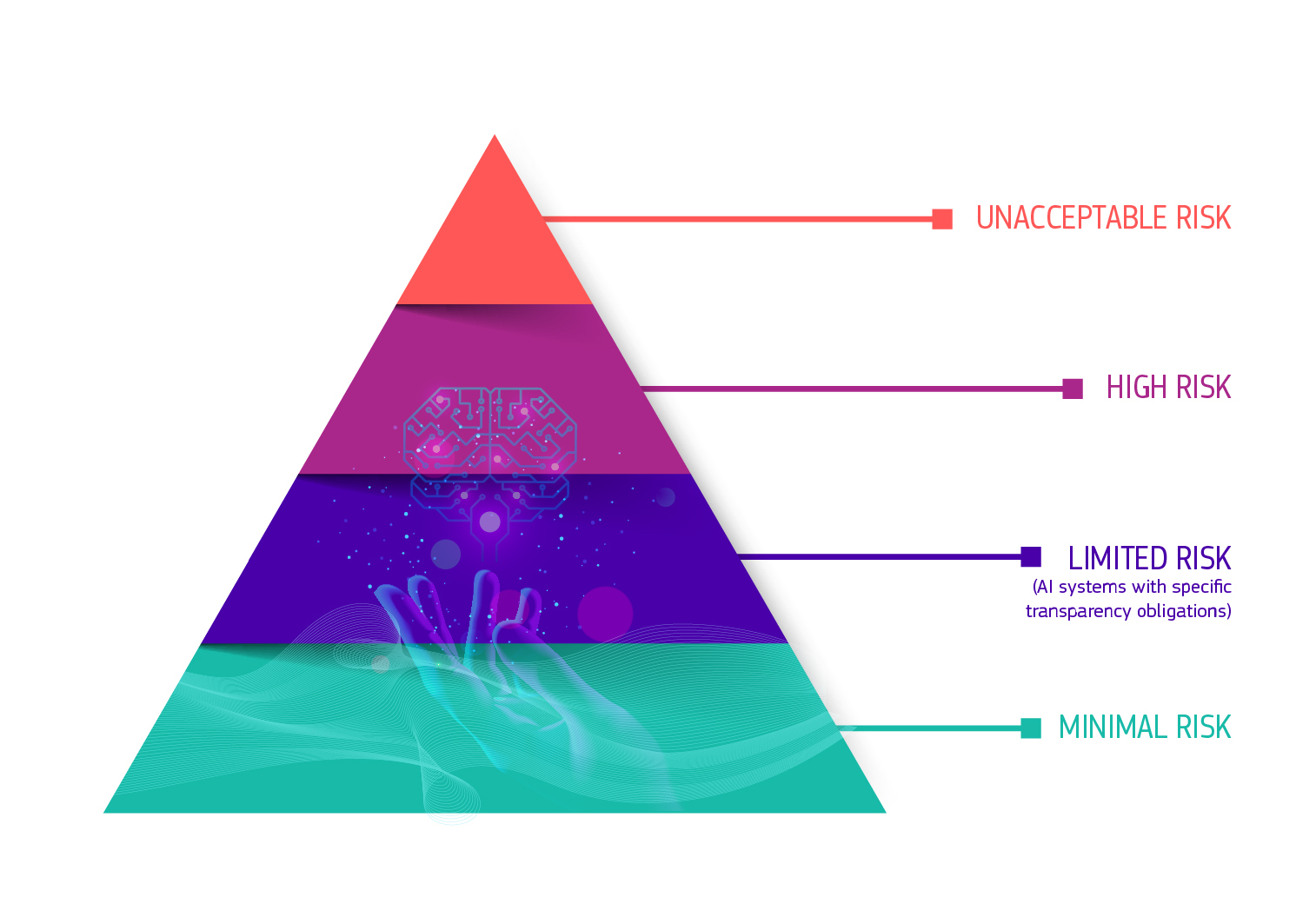

Een risicogebonden aanpak

De Commissie stelt in de verordening een op risico gebaseerde aanpak voor, met vier risiconiveaus. Uit de tekst valt op te maken dat zij daarbij uitgaat van het principe: “Hoe hoger het risico, hoe strikter de regels.” We beginnen onderaan de piramide:

AI-systemen die behoren tot de categorie van minimaal tot geen risico:

De overgrote meerderheid van de AI-systemen die momenteel in de EU

worden gebruikt, vallen onder deze categorie. Denk bijvoorbeeld aan de

spamfilter van je mailbox. Op deze categorie zijn de normale Europese regels voor productveiligheid op de interne markt van toepassing.

AI-systemen met een laag risico

Bepaalde AI-systemen, zoals chatbots of deepfake-technologie, dragen bepaalde risico’s met zich mee, zoals bijvoorbeeld het risico op manipulatie. Aan deze systemen worden transparantievereisten verbonden. Meer precies moeten mensen op de hoogte gesteld worden dat ze met een AI-systeem te maken hebben, tenzij dit duidelijk is. De systemen moeten ook gelabeld worden en daarbij bekendmaken dat de inhoud kunstmatig is gecreëerd of gemanipuleerd (zie ook punt (70) p.34).

Verder worden AI-leveranciers aangemoedigd om (sectorale) gedragscodes op te stellen (zie ook Titel IX, p.80 in de officiële tekst).

AI-systemen met een hoog risico (Titel III p.45)

Wat wordt hiermee bedoeld?

- AI-systemen die als veiligheidscomponent van een product fungeren en onder de sectorale EU-wetgeving vallen. Deze systemen zijn opgenomen in bijlage II bij de AI-verordening.

- AI-systemen

die voor gezondheids- of veiligheidsrisico’s kunnen zorgen, of voor risico’s op negatieve gevolgen voor de grondrechten bij bepaalde toepassingen

(zie hieronder).

In grote lijnen:- Biometrische identificatie: Biometrische identificatie van natuurlijke personen in real time of op afstand (Annex III 1(a)). Bijvoorbeeld systemen voor gezichtsherkenning. Denk bijvoorbeeld aan het stopgezette experiment van de federale politie op de luchthaven van Zaventem. Bepaalde vormen van biometrische identificatie zijn ook verboden (zie verder).

- Beheer en exploitatie van essentiële infrastructuur (Annex III 2(a)). Bijvoorbeeld AI-systemen met betrekking tot het elektriciteitsnet.

- Onderwijs (Annex III 3(a-b)). Bijvoorbeeld AI-systemen gebruikt voor het beoordelen, bepalen van toegang, toelating of toewijzing van personen of studenten/leerlingen.

- Arbeidsmarkt (Annex III 4(a-b)). Bijvoorbeeld AI-systemen die gebruikt worden voor het rekruteren, screenen en evalueren van kandidaten of het evalueren en controleren van personeel.

- Essentiële publieke en private diensten (Annex III 5(a-c)). Bijvoorbeeld De beoordeling van kredietwaardigheid of toegang tot uitkering door AI-systemen.

- Ordehandhaving (Annex III 6(a-g)). Bijvoorbeeld voorspellende politiesystemen, waar de federale politie in ons land mee werkt.

- Migratie, asiel en grenscontrole (Annex III 6-7). Bijvoorbeeld het ondersteunen door AI-systemen van onderzoek naar de ontvankelijkheid van asiel-/visum-/verblijfsvergunningsaanvragen.

- Justitie (Annex III 8). Bijvoorbeeld AI-systemen die bedoeld zijn om een rechterlijke instantie bij te staan bij het onderzoeken en interpreteren van feiten en het recht.

Uitzonderingen

- Niet van toepassing op wapens en militair gebruik.

- Andere uitzonderingen (zie Annex 2)

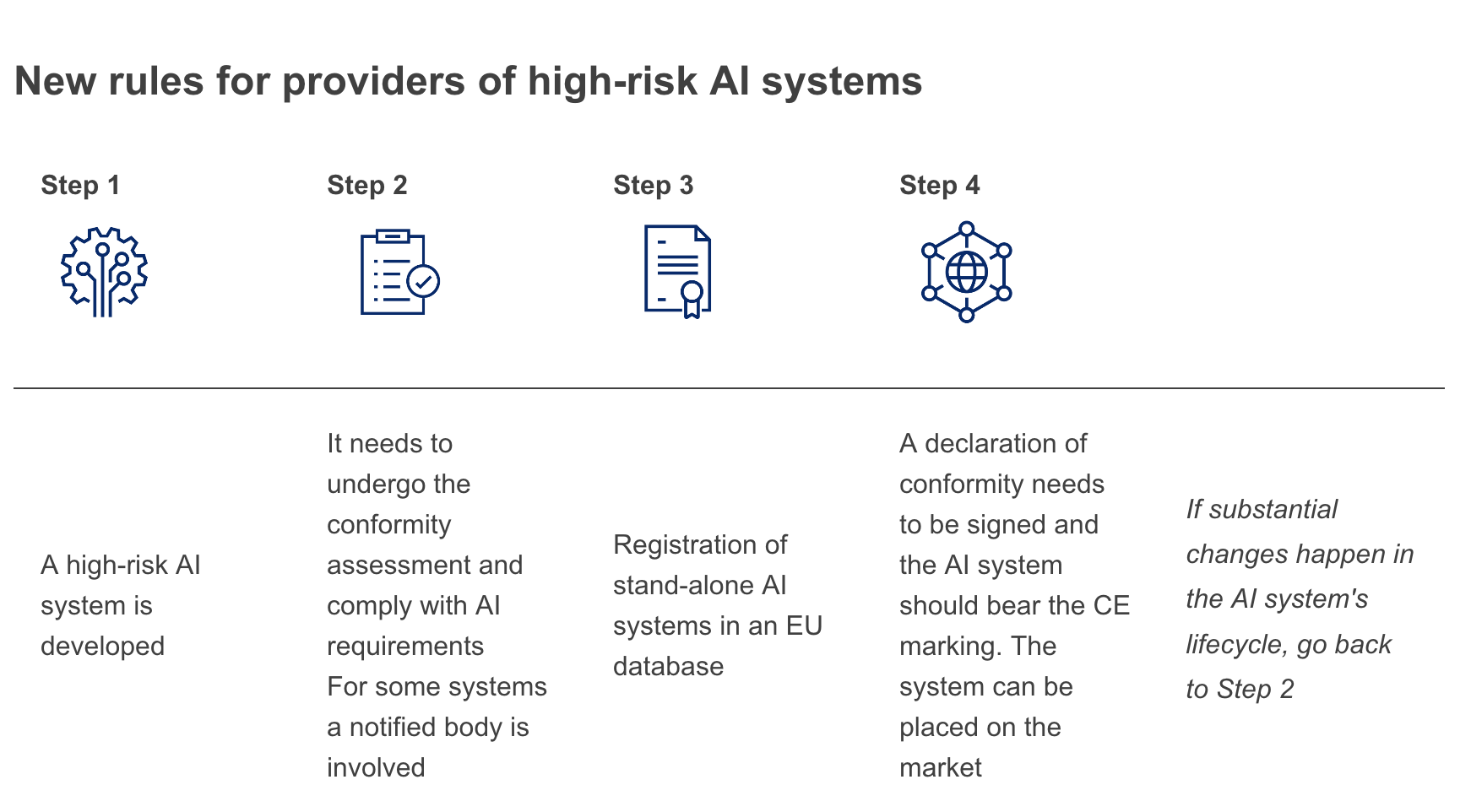

Wat als je AI-systeem geclassificeerd wordt als een hoog risico?

AI-systemen die een hoog risicokarakter hebben, zullen moeten voldoen aan de voorschriften van hoofdstuk 2 (p.46 van de officiële tekst) en de verplichtingen van hoofdstuk 3 (p.52 van de officiële tekst).

In grote lijnen:

Het AI-systeem moet goedgekeurd worden

vooraleer het op de Europese markt kan komen. Zodra het AI-systeem op de

markt is, zijn de autoriteiten belast met het markttoezicht, zorgen de

gebruikers voor menselijk toezicht en monitoring, en hanteren de

aanbieders een systeem voor monitoring na het in de handel brengen.

Aanbieders en gebruikers moeten ook ernstige incidenten en storingen

melden.

Vereisten en verplichtingen voor aanbieders:

- Compliance en risicobeheer (5.2.3 p. 13-14, artikel 8 en 9):

- AI-systemen met een hoog risico moeten voldoen aan de onderstaande eisen

- Er zou ook een risicobeheersysteem opgezet en gehanteerd moeten worden en de werking ervan moet gedocumenteerd worden. Risicobeheer moet een continu herhalend proces zijn dat gedurende de gehele levenscyclus van het

systeem wordt uitgevoerd. - Bij het toezicht op de naleving van deze vereisten zou rekening gehouden moeten worden met het beoogde doel van het AI-risicosysteem en het risicobeheersysteem.

- Data (artikel 10):

- Datasets zouden voldoende relevant, representatief, foutloos en volledig moeten zijn met het oog op het te behalen doel. Datasets zouden ook rekening moeten houden met de kenmerken, eigenschappen of elementen die eigen zijn aan de specifieke geografische en/of functionele omgeving waarin het AI-systeem zal worden gebruikt.

- Er zou ook moeten worden voldaan aan regels voor databeheer. Zo zou bijvoorbeeld aandacht moeten worden besteed aan de dataverzameling, de voorbereiding van de datasets (annotatie, labeling, opkuisen, verrijking ed.), onderzoek met het oog op mogelijke vooroordelen ("bias").

- Documentatie (artikel 11-12):

- AI-systemen met een hoog risico moeten ontworpen en ontwikkeld worden met voorzieningen voor de automatische registratie van gebeurtenissen ("logs") terwijl het AI-systeem in werking is. Dit register van bewijsmateriaal zal vermoedelijk de

basis vormen van audits door derden.

- Verder zou het bijhouden van bepaalde technische documentatie vereist zijn, zoals documentatie over de algemene kenmerken, mogelijkheden en beperkingen van het systeem, algoritmen, data, ontwikkelings-, test- en valideringsprocessen die zijn gebruikt, alsmede een gedetailleerde beschrijving van het risicobeheersysteem.

- AI-systemen met een hoog risico moeten ontworpen en ontwikkeld worden met voorzieningen voor de automatische registratie van gebeurtenissen ("logs") terwijl het AI-systeem in werking is. Dit register van bewijsmateriaal zal vermoedelijk de

basis vormen van audits door derden.

- Transparantie (artikel 13):

Gebruikers moeten begrijpen hoe AI-uitkomsten tot stand komen via wat

in feite een AI-label is, waarop bijvoorbeeld contactgegevens staan om

fouten te laten corrigeren.

- Menselijk toezicht (artikel

14): Ook is het noodzakelijk dat natuurlijke personen de controle en

toezicht kunnen behouden over het functioneren van AI-systemen. Daarvoor

zijn onder andere technische en organisatorische maatregelen en opleiding voor nodig.

- Robuustheid en weerbaarheid (artikel 15): AI-systemen met een hoog risico moeten gedurende hun hele levenscyclus

consistent presteren en voldoen aan een hoog niveau van nauwkeurigheid,

robuustheid en beveiliging. Robuustheid moet inhouden dat het systeem

bestand is tegen fouten, storingen of inconsistenties die zich kunnen

voordoen in het systeem of in de omgeving waarin het systeem

functioneert, met name als gevolg van de interactie met natuurlijke

personen of software- of hardwaresystemen. Het AI-systeem moet ook

veilig en weerbaar zijn tegen pogingen van kwaadwillende derden om het

gebruik of de prestaties van het systeem te wijzigen, met de bedoeling

misbruik te maken van de zwakke plekken ervan.

Welke regels zijn er voor de aanbieders?

Aanbieders moeten voldoen aan de vereisten voor AI-systemen met een hoog risico en hebben daarnaast volgende verplichtingen:

- Het opzetten en toepassen van een kwaliteitszorgsysteem in zijn organisatie (artikel 17)

- Het opstellen en bijhouden van technische documentatie (artikel 18)

- De door het AI-systeem automatisch gegenereerde logbestanden moeten bewaard blijven, om gebruikers in staat te stellen de werking van het AI-systeem met hoog risico te controleren (artikel 20)

- Een conformiteitsbeoordeling laten doorvoeren en de conformiteitsverklaring ondertekenen (artikel 19). Een conformiteitsattest heeft een maximale geldigheidsduur van vijf jaar. Wat betreft de conformiteitsbeoordeling is er is een onderscheid tussen (zie ook p.13-14):

- AI-systemen die veiligheidscomponenten van producten zijn. Zij volgen een systeem met procedures die reeds zijn vastgesteld in het kader van de desbetreffende sectorale wetgeving inzake productveiligheid.

- Biometrische identificatie van natuurlijke personen op afstand moeten worden onderworpen aan een conformiteitsbeoordeling door een derde partij

- In andere gevallen is de nieuwe conformiteitsbeoordeling van toepassing. Hierbij zou de implementeerder/gebruiker van het AI-systeem zelf de conformiteit beoordelen.

- Registreren van het AI-systeem in de EU-databank (p.14)

- Nadat het AI-systeem op de markt is gebracht, moet een monitoringsysteem opgezet worden (artikel 17)

- Samenwerken met de markttoezichtsautoriteiten (artikel 23)

- Aanbrengen van een CE-markering (artikel 49 p.68)

Wat met de gebruikers van deze systemen? (artikel 29)

Gebruikers zijn ook gebonden aan specifieke verantwoordelijkheden om te verzekeren dat resterende risico’s tot een minimum worden beperkt. Deze verantwoordelijkheden bevatten onder meer:

- Het AI-systeem volgens de gebruiksaanwijzing bedienen

- Zorgen voor menselijk toezicht bij het gebruik van het AI-systeem

- Toezicht op de werking voor mogelijke risico's

- De leverancier of distributeur op de hoogte stellenvan elk ernstig incident of elke storing

- Bestaande wettelijke verplichtingen blijven van toepassing (bv. AVG)

Wat als er iets misgaat met een AI-systeem met een hoog risico?

- De verantwoordelijkheid ligt in principe bij de persoon of instantie die het systeem aanbiedt. Dit betekent dat de aanbieder risico's loopt door een risicovol product op de markt te brengen, en dat aanbieders dus goed toezicht moet houden op de toeleveringsketen en kwaliteitscontroleprocedures (zie ook (52)-(53) p.31 van de officiële tekst).

- Importeurs, distributeurs en vertegenwoordigers van buitenlandse bedrijven moeten ook aan specifieke verplichtingen voldoen (zie ook artikel 26-28 p. 56-57 van de officiële tekst).

Verboden toepassingen (zie officiële tekst Titel II p.43-45)

De Commissie verbiedt een beperkt aantal AI-systemen omdat ze fundamentele rechten kunnen schenden:

- AI-systemen die gebruik maken van "subliminale technieken" om

menselijk gedrag te manipuleren waarbij dat gedrag zodanig verandert wordt dat die persoon "fysieke of psychische schade aan zichzelf of anderen toebrengt of kan toebrengen". Het gebruik van gedragsgerichte technieken in marketing is hier een voorbeeld van.

- AI-systemen die micro-targeting hanteren, die zo de kwetsbaarheid van een groep vanwege hun leeftijd of fysieke of mentale beperking uitbuiten en het gedrag van een persoon behorend tot die groep zodanig manipuleert ("wezenlijk te verstoren") dat die zichzelf of anderen fysieke of psychische schade toebrengt of dreigt toe te brengen. Bijvoorbeeld een stuk speelgoed dat voice assistance gebruikt om een kind ertoe aan te zetten iets gevaarlijks te doen.

- AI-systemen die door of namens overheidsinstanties wordt gebruikt voor sociale scoring (samengevat), zoals AI-systemen die individueel gedrag bijhouden of invloed kunnen hebben op aanwervingen en rechterlijke beslissingen. Dit wordt momenteel wel toegepast in onder andere China en de VS.

- Het gebruik van "biometrische identificatie

in real time op afstand in openbare ruimtes met het oog op

rechtshandhaving", met een aantal uitzonderingen, die in verschillende

paragrafen worden beschreven. Willekeurige surveillance van personen

wordt verboden indien het niet gebruikt wordt voor een specifiek doel.

Andere overheidsinstanties (bijvoorbeeld scholen of transport) en

particuliere actoren, zoals bijvoorbeeld voetbalclubs,

mogen de technologie wel gebruiken. Biometrische identificatie is

voornamelijk bekend voor gezichtsherkenningstechnologie, maar ook

vingerafdruk- of handafdruktechnologie valt hieronder.

Real-time betekent: "zonder aanzienlijke vertraging", hetgeen relevant is voor de tijd tussen het afnemen van biometrische gegevens, de vergelijking met het centrale gegevensbestand en de identificatie van een persoon. Indirecte biometrische identificatie voor rechtshandhaving is wel nog toegelaten. De tekst laat dus ruimte voor bijvoorbeeld het gebruik van software zoals Clearview AI door politiediensten.

De verordening voegt daar echter aan toe dat er talrijke uitzonderingen op dit verbod zijn, waaronder het toestaan dat de politie dergelijke systemen gebruikt om daders of verdachten te vinden van een strafbaar feit waarop een minimumstraf van drie jaar staat. De lidstaten kunnen het verbod ook omzeilen op grond van bepalingen van nationaal recht

Andere uitzonderingen:

- Militaire toepassingen vallen niet onder de verordening.

- Onderzoek voor legitieme doeleinden in verband met de verboden AI-systemen is toegelaten, zolang het onderzoek geen schade berokkent aan natuurlijke personen en in overeenstemming is met erkende ethische normen voor wetenschappelijk onderzoek. Scraping bijvoorbeeld, een techniek die Cambridge Analytica gebruikte, is niet verboden.

- Er zijn ook uitzonderingen voor AI-systemen met biometrische identificatie die gebruikt worden voor migratie, asiel en grenscontrole (zie officiële tekst p. 28 (39)).

Transparantie

Aanbieders van AI-systemen moeten verzekeren dat gebruikers op de hoogte worden gebracht dat ze te maken hebben met een AI-systeem

Er zijn verplichte transparantieverplichtingen voor AI-systemen die- interactie hebben met mensen

- emoties "detecteren" of sociale categorieën interpreteren op basis van biometrische gegevens

- inhoud genereren of manipuleren, bv. deepfake-technologie

Handhaving

Lidstaten (artikel 59, artikel 70 en verder) (zie officiële tekst p.72)

- Net als bij de AVG ligt een groot deel van de afdwingingsverantwoordelijkheid bij de lidstaten. De AI-verordening schrijft voor dat de autoriteiten van de lidstaten markttoezicht en controle op AI-systemen uitoefenen. De lidstaten zouden de mogelijkheid hebben om actoren die de regels overtreden

een administratieve boete op te leggen die kan oplopen tot maximum 30 miljoen euro of 6 procent van hun wereldwijde omzet. - Op nationaal niveau lijkt het erop dat er meer "nationale bevoegde autoriteiten" zullen worden opgericht of aangewezen, alsmede één "toezichthoudende autoriteit" die uit de verschillende bevoegde autoriteiten zal worden gekozen. Deze zal optreden als markttoezichtautoriteit en kennisgevingsautoriteit.

- Indien de nationale bevoegde autoriteiten niet over voldoende deskundigheid of middelen beschikken of hiertoe niet bereid zijn, kan de Commissie zelf optreden om een consequente toepassing van het recht te waarborgen.

De Europese AI-raad (artikel 56-58)

- Dit orgaan zou ervoor moeten zorgen dat het regelgevend kader op een dynamische manier aangepast wordt en dat de lijst van toepassingsgevallen up-to-date blijft.

- Verder zou de adviserende raad relevante aanbevelingen en adviezen aan de Commissie moeten doen, met betrekking tot de lijst van verboden praktijken op het gebied van AI en de lijst van AI-systemen met een hoog risico.

- De raad bestaat uit één nationale toezichthoudende autoriteit per EU-land, de EU-toezichthouder voor gegevensbescherming en een vertegenwoordiger van de Europese Commissie die het voorzitterschap van het bestuur waarneemt.

- De raad zou worden ondersteund door de administratieve structuur van de Commissie en een nog op te richten expertengroep om waar nodig aanvullende deskundigheid te verstrekken (zie punt 2.2.2 p.96)

EU-databank voor autonome AI-systemen met een hoog risico (artikel 60)

- De databank moet gegevens bevatten over alle autonome AI-systemen die als erg risicovol worden beschouwd, en alle in de databank verwerkte informatie moet toegankelijk zijn voor het publiek. Dit moet voor meer transparantie zorgen en betere toegang tot data voor onderzoek.

Innovatie

Het wetsvoorstel bevat ook enkele initiatieven om innovatie te ondersteunen.

- Wettelijke vrijplaatsen ("regulatory sandboxes") (artikel 53 p.69-70)

Het gebruik van wettelijke vrijplaatsen wordt aangemoedigd om het ontwikkelen en testen van innovatieve AI-systemen te faciliteren. Deelnemers van een vrijplaats zouden overeenkomstig de toepasselijke Europese en nationale aansprakelijkheidswetgeving aansprakelijk blijven voor schade die derden lijden door de experimenten. Meer info over dergelijke sandboxes vind je in onze brAInfood-publicatie.

- Maatregelen voor kleinschalige aanbieders en gebruikers (artikel p.70)

Lidstaten moeten deze doelgroep prioritaire toegang geven tot wettelijke vrijplaatsen/regulatory sandboxes en moeten deze doelgroep gericht informeren over de nieuwe Europese AI-regulering.

Verdere stappen

De ontwerpverordening kan nog aangepast worden met de input van de andere twee Europese politieke organen, namelijk het Europese parlement en de lidstaten in de Europese Raad. Bij algemene goedkeuring moeten de lidstaten deze wetgeving implementeren, maar het kan nog een hele tijd duren vooraleer deze tekst effectief afgekondigd wordt en in werking treedt.

Het AI-coördinatieplan

Naast het voorstel voor een wettelijk kader heeft de Europese Commissie "Een gecoördineerd plan met de EU-landen" en "Nieuwe regels voor machineproducten" gelanceerd.

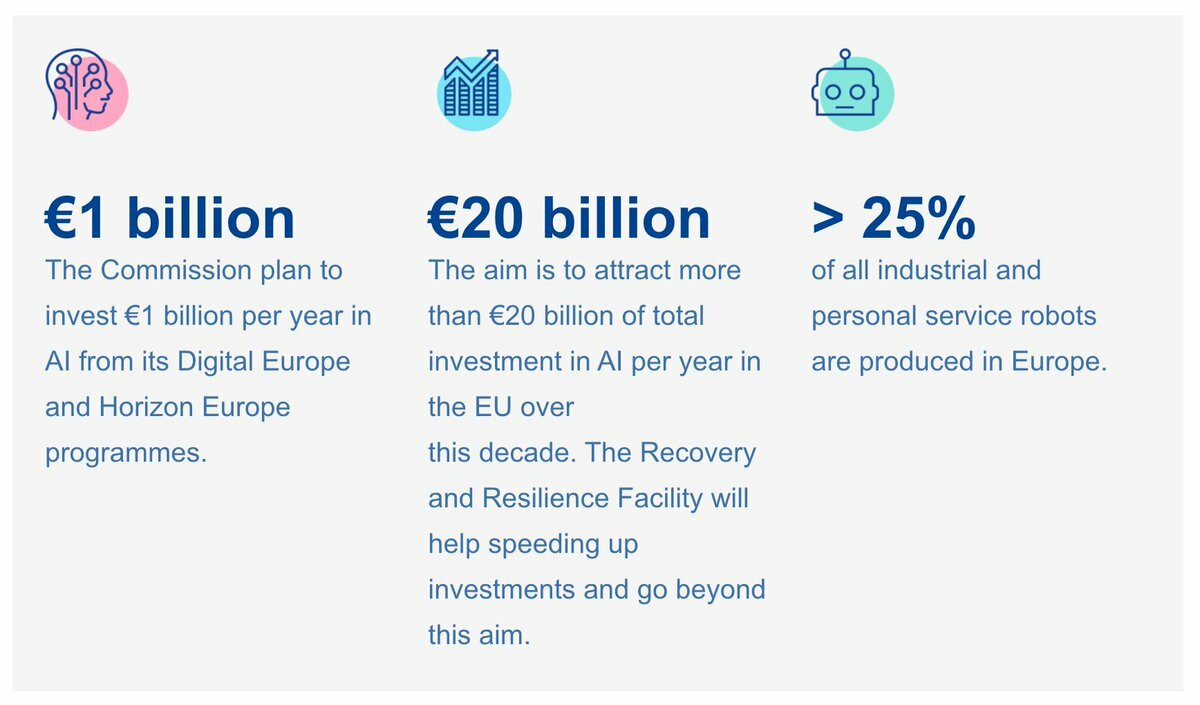

De Nieuwe regels voor machineproducten moeten zorgen voor een veilige integratie in een machine. Het gecoördineerde plan bevat een concrete reeks gezamenlijke acties voor de Europese Commissie en de lidstaten om de EU wereldwijd een leidende rol te laten spelen op het gebied van betrouwbare AI. In het gecoördineerd plan staat dat de EU 1 miljard euro per jaar wil investeren in AI-technologieën. Negentien Europese lidstaten hebben ondertussen al een officiële AI-strategie gelanceerd. België behoort niet tot die groep.

Het gecoördineerd plan is een geüpdate versie van een oorspronkelijk plan uit 2018. Er is een review gemaakt omwille van onder andere de COVID-19 pandemie, de nieuwe plannen rond de Green Deal en technologische ontwikkelingen.

Het plan is opgebouwd rond vier beleidsdoelen:

- Schep voorwaarden voor de ontwikkeling en acceptatie van AI in de EU

- Maak van de EU de juiste plaats: excellentie van het lab tot op de markt

- Zorg ervoor dat AI-technologie de mens centraal zet v

- Bouw strategisch leiderschap in verschillende sectoren

De Commissie voorziet in het plan:

- Een publiek-privaat partnerschap inzake AI, Data en Robotica om een gemeenschappelijke strategische agenda voor onderzoek, innovatie en toepassing voor Europa vast te stellen, uit te voeren en erin te investeren

- Het opzetten van netwerken van expertisecentra voor AI om de uitwisseling van kennis en expertise te bevorderen, samenwerking met het bedrijfsleven te ontwikkelen en diversiteit en inclusie te stimuleren

- Het voorzien van test- en experimenteerinfrastructuur om de allernieuwste technologie te testen in reële omgevingen

- Het opzetten van digitale innovatiehubs die toegang bieden tot technische expertise en testruimtes

- Een AI-on-demand-platform als centrale Europese gereedschapskist met AI-hulpbronnen zoals expertise, algoritmes, softwareframeworks en ontwikkelingsinstrumenten